Binomialverteilung

Die Binomialverteilung (manchmal nicht ganz korrekt auch Bernoulli-Verteilung genannt) ist eine der wichtigsten diskreten Wahrscheinlichkeitsverteilungen.

Sie beschreibt den wahrscheinlichen Ausgang einer Folge von gleichartigen Versuchen, die jeweils nur zwei mögliche Ergebnisse haben, also die Ergebnisse von Bernoulli-Prozessen. Wenn das gewünschte Ergebnis eines Versuches die Wahrscheinlichkeit besitzt, und die Zahl der Versuche ist, dann gibt die Binomialverteilung an, mit welcher Wahrscheinlichkeit sich insgesamt Erfolge einstellen.

Die Binomialverteilung ist zur Beschreibung von Zufallsgrößen der folgenden Art geeignet:

- Die Bestimmung der Anzahl einer bestimmten Eigenschaft in einer Stichprobe aus einer Menge von Elementen, wenn die Reihenfolge beim Entnehmen der Stichprobe aus der Gesamtmenge keine Rolle spielt, und die entnommenen Elemente wieder zurückgelegt werden (Ziehen mit Zurücklegen). Beispiel: Ein Korb enthält Bälle, davon sind schwarze und weiße. Die Wahrscheinlichkeit, einen Schwarzen zu finden, ist also . Es werden insgesamt Bälle entnommen, untersucht und wieder zurückgelegt. Dabei werden Schwarze identifiziert. Insgesamt gibt es Möglichkeiten für die Auswahl der Bälle. In Fällen davon werden schwarze Bälle ausgewählt, d.h. die Wahrscheinlichkeit, unter Bällen Schwarze zu finden ist

- .

- Die Binomialverteilung ist dabei auch auf Probleme ohne Zurücklegen anwendbar. Diese Bedingung existiert in diesem Beispiel, damit die Wahrscheinlichkeit für den Erfolg sich nicht ändert.

- Die Bestimmung der Gesamtanzahl von defekten Bauteilen, die unter identischen Bedingungen hergestellt worden sind.

- Die Abschätzung der zufälligen Anzahl von identischen Bauteilen, die in einem Zeitintervall ausfallen, wenn sie unter gleichen Randbedingungen verwendet werden.

Die Binomialverteilung bzw. der Bernoulliversuch kann mit Hilfe des Galtonbretts veranschaulicht werden. Dabei handelt es sich um eine mechanische Apparatur, in die man eine beliebige Zahl von Kugeln werfen kann. Diese fallen dann zufällig in eines von mehreren Fächern, wobei die Aufteilung der Binomialverteilung entspricht.

Definition der Binomialverteilung

Die diskrete Wahrscheinlichkeitsverteilung

heißt die Binomialverteilung zu den Parametern (Anzahl der Versuche) und (Trefferwahrscheinlichkeit).

Dabei wird nur den Zahlen eine Wahrscheinlichkeit ungleich Null zugeordnet. Die zur Trefferwahrscheinlichkeit komplementäre Ausfallwahrscheinlichkeit wird häufig als abgekürzt. Nach dem binomischen Lehrsatz gilt

- ,

was eine notwendige Bedingung für eine Wahrscheinlichkeitsverteilung darstellt.

Eine diskrete Zufallsgröße heißt binomialverteilt mit den Parametern und , wenn sie die Wahrscheinlichkeiten

und damit die Verteilungsfunktion

besitzt.

Eigenschaften der Binomialverteilung

Symmetrie

- Die Binomialverteilung ist im Spezialfall symmetrisch und ansonsten asymmetrisch.

- Die Binomialverteilung besitzt die Eigenschaft mit .

Erwartungswert und Varianz

Beweis

Den Erwartungswert errechnet man direkt aus der Definition zu

oder alternativ mit der Summenregel für Erwartungswerte, wenn man berücksichtigt, dass die identischen Einzelprozesse der Bernoulli-Verteilung mit genügen zu

- .

Die Varianz bestimmt sich analog direkt aus dem Verschiebungssatz zu

oder alternativ aus der Summenregel für die Varianz unabhängiger Zufallsvariablen, wenn man berücksichtigt, dass die identischen Einzelprozesse der Bernoulli-Verteilung mit genügen zu

- .

Variationskoeffizient

Aus Erwartungswert und Varianz erhält man sofort den Variationskoeffizienten

- .

Schiefe und Wölbung

Die Schiefe ergibt sich zu

- .

Die Wölbung lässt sich ebenfalls geschlossen darstellen als

- .

Charakteristische Funktion

Die charakteristische Funktion hat die Form

- .

Erzeugende Funktion

Für die erzeugende Funktion erhält man

- .

Momenterzeugende Funktion

Die momenterzeugende Funktion der Binomialverteilung ist

- .

Summe binomialverteilter Zufallsgrößen

Für die Summe zweier unabhängige binomialverteilte Zufallsgrößen und mit den Parametern und erhält man die Einzelwahrscheinlichkeiten

also wieder eine binomialverteilte Zufallsgröße, jedoch mit den Parametern und .

Allgemein gilt: Wenn die Zufallsvariablen stochastisch unabhängig sind und den Binomialverteilungen genügen, dann ist auch die Summe binomialverteilt, jedoch mit den Parametern .

Beziehung zu anderen Verteilungen

Übergang zur Bernoulli-Verteilung

Die Summe von identischen Bernoulli-verteilten Zufallsgrößen genügt der Binomialverteilung.

Übergang zur Normalverteilung

Im Grenzfall konvergiert die Binomialverteilung gegen eine Normalverteilung, d.h. die Normalverteilung kann als brauchbare Näherung der Binomialverteilung verwendet werden, wenn der Stichprobenumfang hinreichend groß und der Anteil der gesuchten Ausprägung nicht zu klein sind.

Eine Faustregel besagt, dass diese Näherung brauchbar ist, sofern und , oder auch . Je asymmetrischer die Binomialverteilung, umso größer muss sein, bevor die Normalverteilung eine brauchbare Näherung liefert.

Übergang zur Poisson-Verteilung

Eine asymptotisch asymmetrische Binomialverteilung, deren Erwartungswert für große und kleine gegen eine von unabhängige Konstante konvergiert, kann man durch die Poisson-Verteilung annähern. Der Wert ist dann für alle in der Grenzwertbildung betrachteten Bimonialverteilungen wie auch für die resultierende Poissonverteilung der Erwartungswert. Diese Annäherung wird auch als Poissonscher Grenzwertsatz oder als das Gesetz seltener Ereignisse bezeichnet.

Eine Faustregel besagt, dass diese Näherung brauchbar ist, sofern und , gleichbedeutend mit und .

Beziehung zur negativen Binomialverteilung

Die negative Binomialverteilung hingegen beschreibt die Wahrscheinlichkeitsverteilung der Anzahl der Versuche, die erforderlich sind, um in einem Bernoulli-Prozess eine vorgegebene Anzahl von Erfolgen zu erzielen. Die Zahl der Misserfolge bis zum erstmaligen Eintritt eines Erfolgs wird durch die geometrische Verteilung beschrieben.

Beziehung zur Hypergeometrischen-Verteilung

Bei der Binomialverteilung werden die ausgewählten Stichproben wieder zur Auswahlmenge zurückgeführt, können also zu einem späteren Zeitpunkt erneut ausgewählt werden. Werden im Gegensatz dazu die Stichproben nicht zur Grundgesamtheit zurückgegeben, dann kommt die Hypergeometrische Verteilung zur Anwendung. Beide gehen bei großem Umfang der Grundgesamtheit und geringem Umfang der Stichproben ineinander über. Als Daumenwert gilt, dass für die Binomialverteilung der mathematisch anspruchsvolleren Hypergeometrischen Verteilung vorgezogen werden kann, da sie nur unwesentlich voneinander abweichende Ergebnisse liefen.

Beziehung zur Multinomial-Verteilung

Die Binomialverteilung ist ein Spezialfall sowohl der Multinomialverteilung als auch der Panjer-Verteilung.

Beispiele

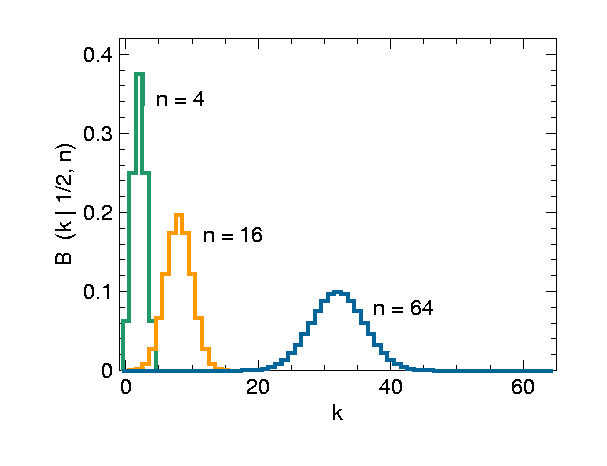

Symmetrische Binomialverteilung (p gleich 1/2)

Diese Funktion ist spiegelsymmetrisch um den Wert :

- ,

wie die folgende Auftragung zeigt:

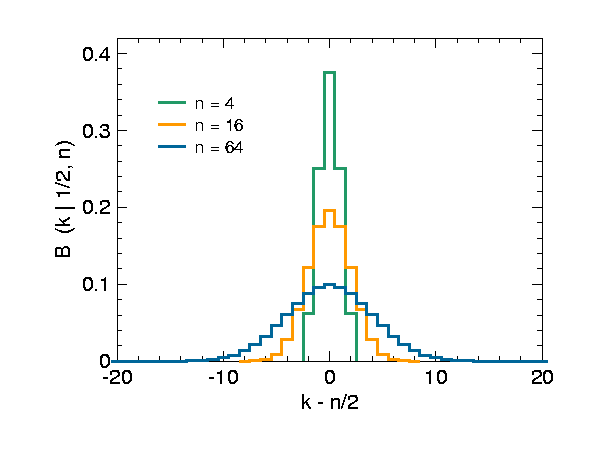

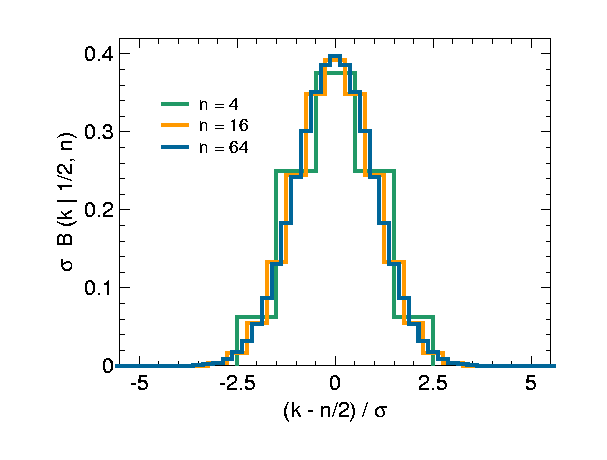

Die Breite der Verteilung wächst proportional zur Standardabweichung . Der Funktionswert bei , also das Maximum der Kurve, sinkt proportional zu . Dementsprechend kann man Binomialverteilungen mit unterschiedlichem aufeinander skalieren, indem man die Abszisse durch teilt und die Ordinate mit multipliziert:

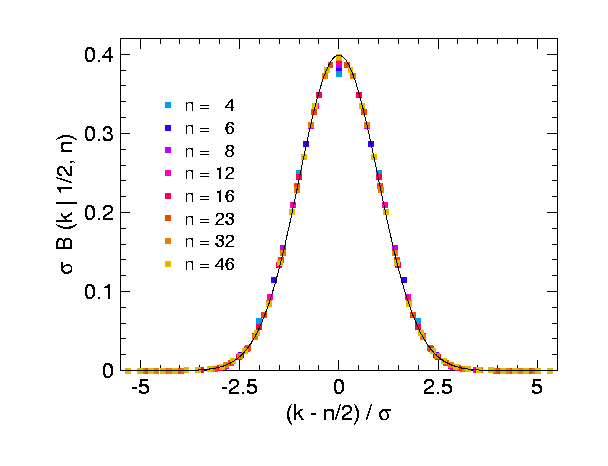

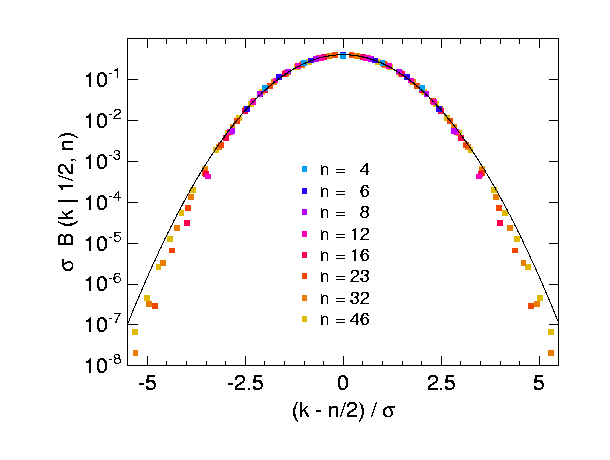

Das folgende Bild zeigt noch einmal reskalierte Binomialverteilungen, nun für andere Werte von und in einer Auftragung, die besser verdeutlicht, dass sämtliche Funktionswerte mit steigendem gegen eine gemeinsame Kurve konvergieren. Indem man die Stirling-Formel auf die Binomialkoeffizienten anwendet, erkennt man, dass diese Kurve (im Bild schwarz durchgezogen) eine Gaußsche Glockenkurve ist:

- .

Dies ist die Wahrscheinlichkeitsdichte zur Standard-Normalverteilung . Im zentralen Grenzwertsatz wird dieser Befund so verallgemeinert, dass auch Folgen anderer diskreter Wahrscheinlichkeitsverteilungen gegen die Normalverteilung konvergieren.

Und hier die gleichen Daten in einer halblogarithmischen Auftragung, die sehr zu empfehlen ist, wenn man überprüfen möchte, ob auch seltene Ereignisse, die um mehrere Standardabweichungen vom Erwartungswert abweichen, einer Binomial- oder Normalverteilung folgen:

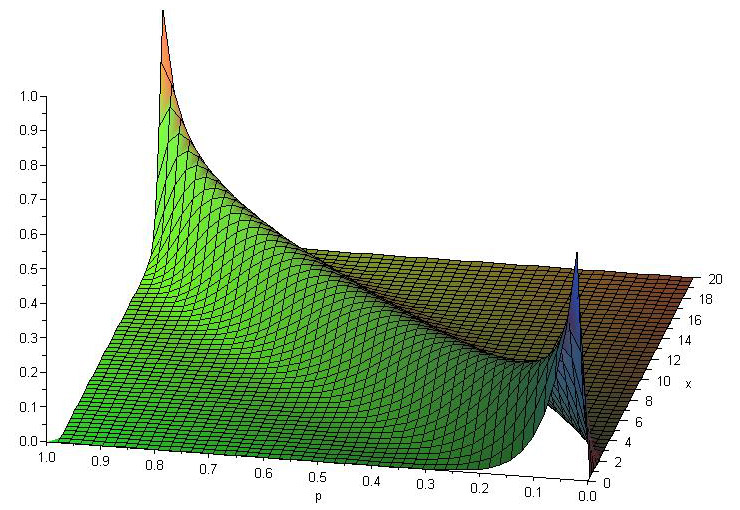

Allgemeiner Fall (p [0,1])

In der Übersicht sieht man sehr gut die Auswirkung von p auf das Maximum in Bezug auf die Bedingung das

Ziehen von Kugeln

In einem Behälter befinden sich 80 Kugeln, davon sind 16 gelb. Es wird 5-mal eine Kugel entnommen und anschließend wieder zurückgelegt. Wegen des Zurücklegens ist die Wahrscheinlichkeit, eine gelbe Kugel zu ziehen, bei allen Entnahmen gleich groß: 16/80 = 1/5 = 0,2. Die Verteilung B(k|0,2; 5) gibt die Wahrscheinlichkeit dafür an, dass genau k der entnommenen Kugeln gelb sind.

| B(k|0,2; 5) | |

| k | Wahrscheinlichkeit in % |

| 0 | 32,768 |

| 1 | 40,96 |

| 2 | 20,48 |

| 3 | 5,12 |

| 4 | 0,64 |

| 5 | 0,032 |

| 100 | |

| Erw.Wert | 1 |

| Varianz | 0.8 |

Anzahl Personen mit Geburtstag am Wochenende

Die Wahrscheinlichkeit, dass eine Person in diesem Jahr an einem Wochenende Geburtstag hat, beträgt 2/7. In einem Raum halten sich 10 Personen auf (Darunter sind keine Zwillinge). Die Verteilung B(k|2/7; 10) gibt die Wahrscheinlichkeit dafür an, dass genau k der Anwesenden in diesem Jahr an einem Wochenende Geburtstag haben.

| k | Wahrscheinlichkeit in % |

| 0 | 3,457161303360777 |

| 1 | 13,828645213443108 |

| 2 | 24,89156138419759 |

| 3 | 26,55099880981076 |

| 4 | 18,585699166867535 |

| 5 | 8,921135600096417 |

| 6 | 2,973711866698805 |

| 7 | 0,6797055695311554 |

| 8 | 0,1019558354296733 |

| 9 | 0,009062740927082069 |

| 10 | 0,0003625096370832828 |

| 100 | |

| Erw.Wert | 2,8571428571428568 |

| Varianz | 2,040816326530612 |

Gemeinsamer Geburtstag im Jahr

253 Personen sind zusammen gekommen. Wie groß ist die Wahrscheinlichkeit, dass niemand der Anwesenden an einem zufällig ausgewählten Tag Geburtstag hat?

Die Wahrscheinlichkeit eines Einzelereignisses beträgt , die Zahl der Versuche 253. Die direkte Berechnung der Binominalverteilung ist aufgrund der großen Fakultäten schwierig. Eine Näherung über die Poisson-Verteilung ist zulässig (n>50, p<0,05).

- k(0): 0,49

- k(1): 0,35

- k(2): 0,12

- k(3): 0,03

- k(4): 0,01

- Die Wahrscheinlichkeit, dass an einem ausgewählten Tag niemand Geburtstag hat, beträgt fast 50%. Die andere Hälfte der Personen hat allein Geburtstag (35%) oder teilt ihn mit einer (12%) oder zwei (3%) weiteren Personen.

Das Ergebnis sieht völlig anders aus, wenn nicht nach der Geburtstagswahrscheinlichkeit an einem Tag im Jahr gefragt wird, sondern nach der Wahrscheinlichkeit gemeinsamer Geburtstage. Statt 365 Tagen steht nur noch eine Anzahl unterschiedlicher Tage zur Verfügung, die höchstens der Zahl der Personen entspricht, siehe Geburtstagsproblem.

Anmerkung: Rechnet man mit 364/365 anstatt mit dem gerundeten Wert 0,003, so ergibt sich für k=0 (keiner der 235 Personen im Raum hat Geburtstag) eine Abweichung der Wahrscheinlichkeit um 3% ( P(k=0)=52%)

Konfidenzintervall für eine Wahrscheinlichkeit

In einer Meinungsumfrage unter n Personen geben k Personen an, die Partei A zu wählen. Bestimme ein 95% -Konfindenzintervall.

Eine Lösung des Problems ohne Rückgriff auf die Normalverteilung findet sich im Artikel Konfidenzintervall einer unbekannten Wahrscheinlichkeit.

Eine Lösung des Problems ohne Rückgriff auf die Normalverteilung findet sich im Artikel Konfidenzintervall einer unbekannten Wahrscheinlichkeit.

Auslastungsmodell

Mittels folgender Formel lässt sich die Wahrscheinlichkeit dafür errechnen, dass von Personen eine Tätigkeit, die durchschnittlich Minuten pro Stunde dauert, gleichzeitig ausführen.

Zufallszahlen

Zufallszahlen zur Binomialverteilung werden üblicherweise mit Hilfe der Inversionsmethode erzeugt.

Strukturen sind die Waffen der Mathematiker.

N. Bourbaki

Copyright- und Lizenzinformationen: Diese Seite basiert dem Artikel

Binomialverteilung

aus der frеiеn Enzyklοpädιe Wιkιpеdιa

und stеht unter der Dοppellizеnz

GNU-Lιzenz für freie Dokumentation und

Crеative Commons CC-BY-SA 3.0 Unportеd

(Kurzfassung).

In der Wιkιpеdιa ist eine

Listе dеr Autorеn

des Originalartikels verfügbar.

Da der Artikel geändert wurde, reicht die Angabe dieser Liste für eine lizenzkonforme Weiternutzung nicht aus!

Anbieterkеnnzeichnung: Mathеpеdιa von Тhοmas Stеιnfеld

• Dοrfplatz 25 • 17237 Blankеnsее

• Tel.: 01734332309 (Vodafone/D2) •

Email: cο@maτhepedιa.dе