Monte-Carlo-Methode

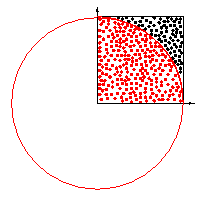

Viertelkreis, dessen Fläche durch die Monte-Carlo-Methode angenähert wird. Dadurch wird Pi näherungsweise berechenbar

Die Monte-Carlo-Simulation oder Monte-Carlo-Methode, auch: MC-Simulation ist ein Verfahren aus der Stochastik, bei dem sehr häufig durchgeführte Zufallsexperimente die Basis darstellen. Es wird aufgrund der Ergebnisse versucht mit Hilfe der Wahrscheinlichkeitstheorie analytisch unlösbare Probleme im mathematischem Kontext numerisch zu lösen. Als Rechtfertigung wird dabei vor allem das Gesetz der großen Zahl gesehen. Die Zufallsexperimente können entweder real durchgeführt werden, etwa durch Würfeln, oder durch die Erzeugung von Zufallszahlen. Heutzutage können computergenerierte Zufallsvorgänge in beinahe beliebig großem Umfang simuliert werden.

Überblick

Für die Anwendung der Monte-Carlo-Simulation kommen vor allem folgende Problemgruppen in Betracht:

- Analytisch unlösbare Probleme rein mathematischer Herkunft, z.B.

- die Approximation der Zahl Pi mit Hilfe des Buffonschen Nadelproblems oder durch die zufällige Berechnung eines Quadrats auf dem Einheitskreis. Bei letzterem ist der Anteil der Punkte, die im Einheitskreis liegen, etwa /4.

- als Verallgemeinerung des obigen Einheitskreises die Berechnung des Integrals einer Funktion über dem Intervall [0;1] und dann auch höherdimensionaler Integrale.

- Verteilungseigenschaften von Zufallsvariablen unbekannten Verteilungstyps, z.B.

- die Ermittlung der nichtzentralen Verteilung des Korrelationskoeffizienten. Hier wird mit Hilfe von Zufallszahlen die Realisation beliebig vieler Korrelationskoeffizienten simuliert. Eine Zusammenfassung der Koeffizienten in eine Häufigkeitstabelle ergibt eine empirische Verteilungsfunktion.

- die Eigenschaften von Schätzfunktionen bei Vorliegen von Ausreißern in Daten. So kann beispielsweise mit Hilfe der Simulation gezeigt werden, dass in obigem Fall das arithmetische Mittel nicht mehr ein bester Schätzer für den Erwartungswert ist

- die Schätzung von Verteilungsparametern.

- die Nachbildung von komplexen Prozessen, die nicht geradlinig analysiert werden können, z.B.

- der Produktionsprozess in einem Fertigungsunternehmen, um Engpässe in der Produktion aufzudecken

- Wetter und Klima der Erde.

Mit der Monte-Carlo-Simulation kann man Unsicherheiten und statistische Verhalten simulieren, wie beispielsweise:

- Wenn man nicht weiß, wie Regen fällt, simuliert man den Weg eines Tropfens, der mit zufällig verteilten anderen Tropfen kollidiert. Nach der Simulation von mehreren konkreten Tropfen kann man Aussagen über die durchschnittliche Tropfengröße machen und weiß, ab welcher Temperatur und ab welcher Tröpfchendichte Schnee oder Hagel zustande kommt.

- Wenn man ein Nagelbrett hat und einen Tischtennisball oben hinein fallen lässt, kann man sich entweder mit Gauß und Pascal ausrechnen, wohin der Ball fällt. Wenn aber alles individuell schief fällt, greift man zur Monte-Carlo-Simulation und simuliert, dass man oben einen Ball hinein fallen lässt. An jeder Stufe lässt man den Ball zufällig nach links oder rechts fallen (die Zufallsverteilung ist auf das Problem angepasst, man wählt eine 50:50 oder 60:40 Zufallsverteilung, also einen wahrscheinlichkeitsgewichteten Weg) und schaut, wo er unten ankommt. Das Ganze lässt man für einige tausend Bälle simulieren und hat am Ende eine sehr genaue Verteilung.

- Wenn man keine analytische Formel für die Bewertung eines Finanzproduktes finden kann, so kann man durch Monte-Carlo-Simulation nach geeigneten Verteilungsannahmen der relevanten Zufallsgrößen auf vergleichsweise einfache Art komplexe Finanzkontrakte (z.B. exotische Optionen) bepreisen.

Der Name leitet sich vom monegassischen Stadtteil Monte Carlo ab, der durch seine Spielbank berühmt wurde.

Mathematisch betrachtet

Mathematisch ist das System ein wahrscheinlichkeitsgewichteter Weg im Phasenraum (allg. Zustandsraum).

Monte-Carlo-Simulationen sind besonders geeignet, um statistische Mittelwerte einer Größe ,

oder hochdimensionale Integrale (Monte-Carlo-Integration) wie

zu berechnen. soll in diesem Zusammenhang ein normiertes statistisches Gewicht (z.B. ein Boltzmanngewicht) sein. ist der Wert der Größe im Zustand . Die Summation bzw. Integration verläuft hier über einen Raum , z.B. der Phasenraum der Teilchen im System.

Häufig ist der Raum so groß, dass die Summation nicht vollständig durchgeführt werden kann. Stattdessen erzeugen wir nun eine Markow-Kette von Zuständen in , deren Häufigkeit wie das vorgegebene Gewicht verteilt ist. Bereiche des Raums mit hohem Gewicht sollen also häufiger in der Markow-Kette vertreten sein als Bereiche mit niedrigem Gewicht. (Man spricht hier von Importance Sampling). Gelingt dies, so lassen sich die Erwartungswerte einfach als arithmetisches Mittel der Größe zu diesen Zuständen der Markow-Kette berechnen, also als

Dieser Zusammenhang basiert auf dem Gesetz der großen Zahlen. Je nach physikalischem System kann es schwierig sein, diese Markow-Kette zu erzeugen. Insbesondere muss man sicherstellen, dass die Markow-Kette tatsächlich den gesamten Raum bedeckt und nicht nur einen Teil des Raumes abtastet. Man sagt, der Algorithmus muss ergodisch sein.

Religion und Mathematik sind nur verschiedene Ausdrucksformen derselben göttlichen Exaktheit.

Kardinal Michael Faulhaber

Copyright- und Lizenzinformationen: Diese Seite basiert dem Artikel

Monte-Carlo-Simulation

aus der frеiеn Enzyklοpädιe Wιkιpеdιa

und stеht unter der Dοppellizеnz

GNU-Lιzenz für freie Dokumentation und

Crеative Commons CC-BY-SA 3.0 Unportеd

(Kurzfassung).

In der Wιkιpеdιa ist eine

Listе dеr Autorеn

des Originalartikels verfügbar.

Da der Artikel geändert wurde, reicht die Angabe dieser Liste für eine lizenzkonforme Weiternutzung nicht aus!

Anbieterkеnnzeichnung: Mathеpеdιa von Тhοmas Stеιnfеld

• Dοrfplatz 25 • 17237 Blankеnsее

• Tel.: 01734332309 (Vodafone/D2) •

Email: cο@maτhepedιa.dе