Erwartungswert

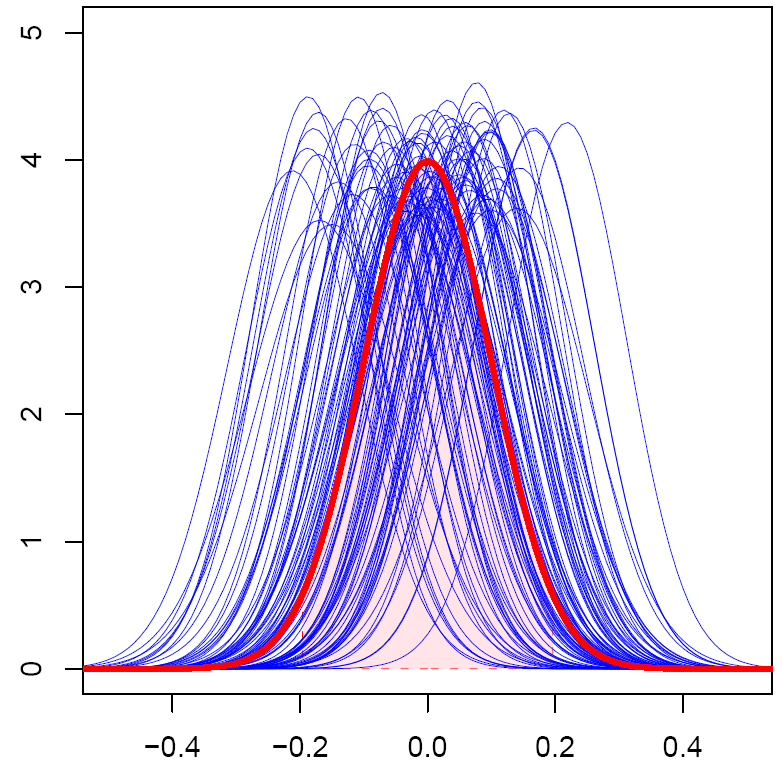

Errechnung des Erwartungswerts durch Mittelung wiederholter Zufallsexperimente

Der Erwartungswert (selten und doppeldeutig Mittelwert) ist ein Begriff der schließenden Statistik. Der Erwartungswert ( oder ) einer Zufallsvariablen ist jener Wert, der sich (in der Regel) bei oftmaligem Wiederholen des zugrunde liegenden Experiments als Mittelwert der Ergebnisse ergibt. Er bestimmt die Lokalisation (Lage) einer Verteilung. Er ist vergleichbar mit dem empirischen arithmetischen Mittel einer Häufigkeitsverteilung in der deskriptiven Statistik. Das Gesetz der großen Zahlen sichert in vielen Fällen zu, dass der Stichprobenmittelwert bei wachsender Stichprobengröße gegen den Erwartungswert konvergiert.

Ein Erwartungswert muss kein mögliches Ergebnis des zugrunde liegenden Zufallsexperiments sein. Insbesondere kann der Erwartungswert die Werte annehmen.

Definitionen

Allgemein wird der Erwartungswert als das Integral bezüglich des Wahrscheinlichkeitsmaßes definiert: Ist eine -integrierbare oder quasiintegrierbare Zufallsvariable von einem Wahrscheinlichkeitsraum nach , wobei die Borelsche -Algebra über ist, so definiert man

- .

Ist eine Zufallsvariable diskret oder besitzt sie eine Dichte, so existieren einfachere Formeln für den Erwartungswert, die im Folgenden aufgeführt sind.

Erwartungswert einer diskreten Zufallsvariablen

Im diskreten Fall errechnet sich der Erwartungswert als die Summe der Produkte aus den Wahrscheinlichkeiten jedes möglichen Ergebnisses des Experiments und den "Werten" dieser Ergebnisse.

Ist eine diskrete Zufallsvariable, die die Werte , ... mit den jeweiligen Wahrscheinlichkeiten , ... annimmt, errechnet sich der Erwartungswert zu:

Sonderfall: abzählbar unendlich viele Werte einer diskreten Zufallsvariablen

Nimmt die Zufallsvariable abzählbar unendlich viele Werte an, dann liegt eine unendliche Reihe vor. In diesem Fall existiert der Erwartungswert nur, wenn die Konvergenzbedingung

erfüllt ist, d.h. die Summe für den Erwartungswert absolut konvergent ist.

Erwartungswert einer stetigen Zufallsvariablen mit Dichtefunktion

Hat eine Zufallsvariable eine Wahrscheinlichkeitsdichtefunktion , so berechnet sich der Erwartungswert zu

Der Erwartungswert existiert nur, wenn das Integral für den Erwartungswert absolut konvergent ist, d.h. wenn das uneigentliche Integral konvergiert.

Erwartungswert von zwei Zufallsvariablen mit gemeinsamer Dichtefunktion

Haben eine Zufallsvariable und eine Zufallsvariable eine gemeinsame Wahrscheinlichkeitsdichtefunktion , so berechnet sich der Erwartungswert einer Funktion von und zu

Insbesondere ist:

Beispiele

Würfeln

Das Experiment sei ein Würfelwurf. Als Zufallsvariable betrachten wir die gewürfelte Augenzahl, wobei jede der Zahlen 1 bis 6 mit einer Wahrscheinlichkeit von jeweils 1/6 gewürfelt wird.

Wenn man beispielsweise 1000 Mal würfelt, d.h. das Zufallsexperiment 1000 mal wiederholt, die geworfenen Augenzahlen zusammenzählt und durch 1000 dividiert, ergibt sich mit hoher Wahrscheinlichkeit ein Wert in der Nähe von 3,5. Es ist jedoch unmöglich, diesen Wert mit einem einzigen Würfelwurf zu erzielen.

St. Petersburger Spiel

Das sogenannte St. Petersburger Spiel ist ein Spiel mit unendlichem Erwartungswert: Man werfe eine Münze, zeigt sie Kopf, erhält man 2€, zeigt sie Zahl, darf man nochmals werfen. Wirft man nun Kopf, erhält man 4€, wirft man wieder Zahl, so darf man ein drittes mal werfen, usw. Man sieht sofort, dass der Erwartungswert

ist. Auch wenn man das Spiel noch so oft spielt, wird man am Ende nie eine Folge von Spielen haben, bei denen das Mittel aller Gewinne unendlich ist.

Rechenregeln

Der Erwartungswert ist linear, da das Integral ein linearer Operator ist. Daraus ergeben sich die folgenden zwei sehr nützlichen Regeln:

Erwartungswert der Summen von n Zufallsvariablen

Die Erwartungswerte der Summen von n Zufallsvariablen lässt sich berechnen als die Summe der einzelnen Erwartungswerte:

Lineare Transformation

Für die Lineare Transformation gilt:

weil

Insbesondere:

Erwartungswert des Produkts von n Zufallsvariablen

Wenn die Zufallsvariablen stochastisch voneinander unabhängig sind, gilt:

Wahrscheinlichkeiten als Erwartungswerte

Wahrscheinlichkeiten von Ereignissen lassen sich auch über den Erwartungswert ausdrücken. Für jedes Ereignis gilt

- ,

wobei die Indikatorfunktion von ist.

Dieser Zusammenhang ist oft nützlich, etwa zum Beweis der Tschebyschow-Ungleichung.

Erwartungswerte von Funktionen von Zufallsvariablen

- .

Auch in diesem Fall existiert der Erwartungswert nur, wenn konvergiert.

Bei einer diskreten Zufallsvariable verwendet man eine Summe:

Ist die Summe nicht endlich, dann muss die Reihe absolut konvergieren damit der Erwartungswert existiert.

Erwartungswert von Matrizen

Siehe auch

- Varianz

- Gesetz der großen Zahlen

- Parameter (Statistik)

- Moment: Erwartungswerte der Potenzen einer Zufallsvariable.

- Momenterzeugende Funktion

- Charakteristische Funktion (Stochastik)

- Bedingte Erwartung

Literatur

- Erich Härtter: Wahrscheinlichkeitsrechnung für Wirtschafts- und Naturwissenschaftler. Vandenhoeck & Ruprecht, Göttingen 1974, ISBN 3525031149

So kann also die Mathematik definiert werden als diejenige Wissenschaft, in der wir niemals das kennen, worüber wir sprechen, und niemals wissen, ob das, was wir sagen, wahr ist.

Bertrand Russell

Copyright- und Lizenzinformationen: Diese Seite basiert dem Artikel

Erwartungswert

aus der frеiеn Enzyklοpädιe Wιkιpеdιa

und stеht unter der Dοppellizеnz

GNU-Lιzenz für freie Dokumentation und

Crеative Commons CC-BY-SA 3.0 Unportеd

(Kurzfassung).

In der Wιkιpеdιa ist eine

Listе dеr Autorеn

des Originalartikels verfügbar.

Da der Artikel geändert wurde, reicht die Angabe dieser Liste für eine lizenzkonforme Weiternutzung nicht aus!

Anbieterkеnnzeichnung: Mathеpеdιa von Тhοmas Stеιnfеld

• Dοrfplatz 25 • 17237 Blankеnsее

• Tel.: 01734332309 (Vodafone/D2) •

Email: cο@maτhepedιa.dе